近日,清华大学高端装备界面科学与技术全国重点实验室智能制造与精密加工团队提出了一种人工智能辅助的增强现实辅助装配指令创作与生成方法(ARAIAG),为高混合制造环境下的增强现实装配引导及程序智能生成提供了创新解决方案。研究成果以"AI-aided Automated AR-Assisted Assembly Instruction Authoring and Generation method"为题,发表于《Journal of Manufacturing Systems》期刊。论文第一作者为清华大学机械工程系博士生林君健,通讯作者为张建富长聘教授,论文作者还包括王健健副教授、冯平法教授、张翔宇助理研究员和郁鼎文教授。

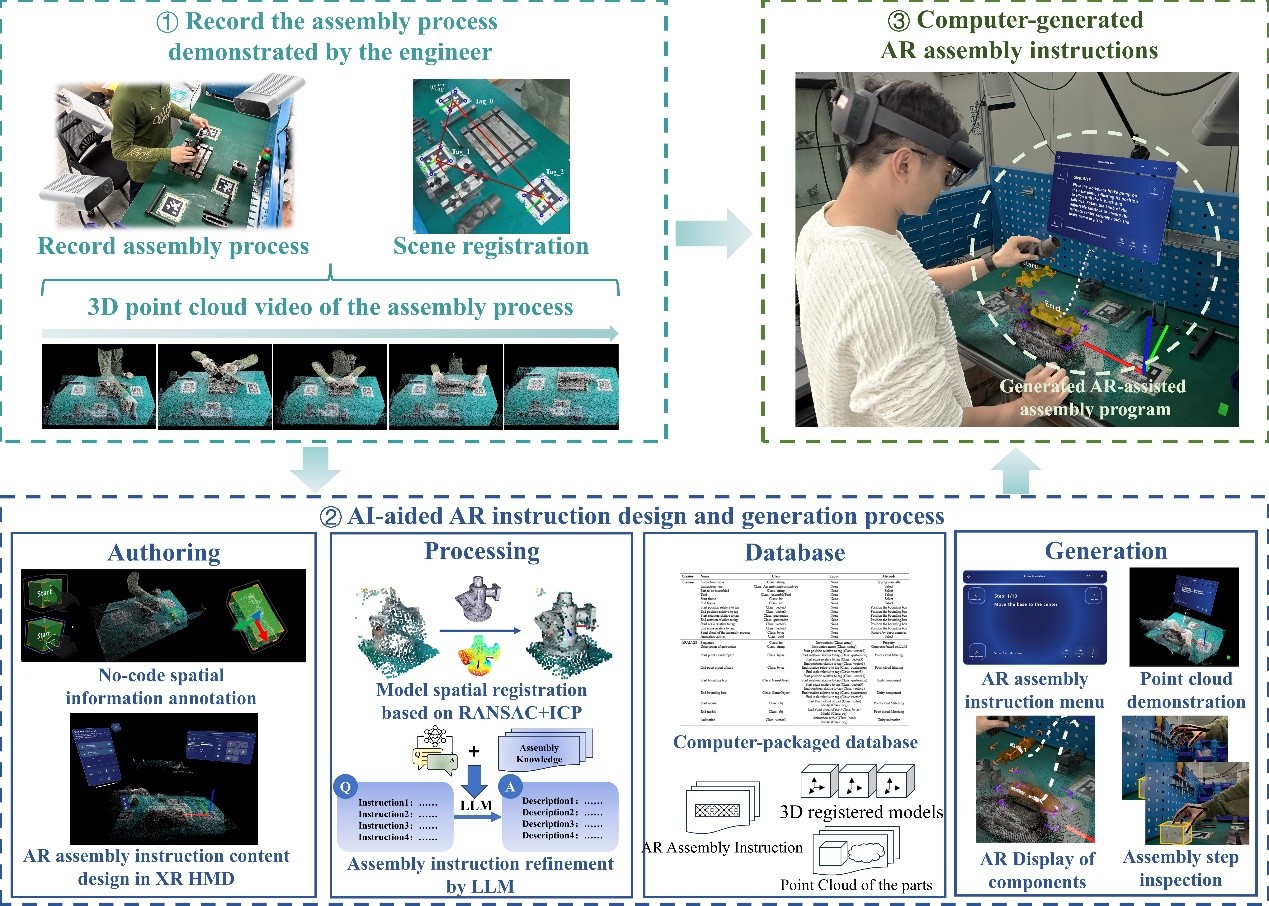

随着制造业向个性化、高混合生产模式转型,传统的增强现实(AR)装配系统面临着开发周期长、成本高、需要专业编程技能等挑战。特别是在产品种类频繁变化的高混合装配环境中,为每个产品变体创建新的AR程序变得极其低效。针对这一问题,研究团队开发了ARAIAG方法(图1),使工程师无需编程即可快速创建和生成AR装配指令。

图1 人工智能辅助的增强现实辅助装配程序创作与生成方法(ARAIAG)

该方法的核心创新包括四个方面:首先,通过多深度相机系统记录工程师的装配演示过程,生成三维点云视频,完整捕获装配过程中的操作细节、零件位姿变化和装配顺序;其次,工程师可在虚拟现实环境中沉浸式地设计

该方法的核心创新包括四个方面:首先,通过多深度相机系统记录工程师的装配演示过程,生成三维点云视频,完整捕获装配过程中的操作细节、零件位姿变化和装配顺序;其次,工程师可在虚拟现实环境中沉浸式地设计AR指令内容,通过自然手势交互添加和编辑装配信息;第三,系统采用随机采样一致性与迭代最近点相结合的算法实现零件模型的自动空间配准;最后,通过后训练的大语言模型自动生成装配指令文本,相较于传统方法在ROUGE-1、ROUGE-2和ROUGE-L F1分数上分别提升了20.96%、67.39%和42.27%,显著减少了装配指令生成的幻觉现象和上下文混淆错误。

该研究的主要贡献在于:提出了基于点云视频装配演示的新型AR指令范式,实现了无代码的创作与生成过程;开发了考虑手部装配轨迹和零件三维模型特征的点云配准算法,实现了虚实空间配准、零件空间定位和装配方向智能识别;构建了标准化的数据库架构和自然人机交互方法,结合大语言模型辅助内容生成,自动创建交互式和指导性的AR装配程序。这项研究为制造业数字化转型提供了重要技术支撑,特别是在需要频繁更新装配程序的高混合制造环境中,可显著降低AR技术工业应用的门槛,提高系统开发效率和智能化水平。

论文链接:https://doi.org/10.1016/j.jmsy.2025.08.019